用AI创造元宇宙,Meta发布最强3D素材生成模型,一分钟创造一个世界

用AI创造元宇宙,Meta发布最强3D素材生成模型,一分钟创造一个世界

文|王沁 王奕昕

编辑|李然

因为有了 AI,Meta 的元宇宙梦不死!

Meta 3D Gen

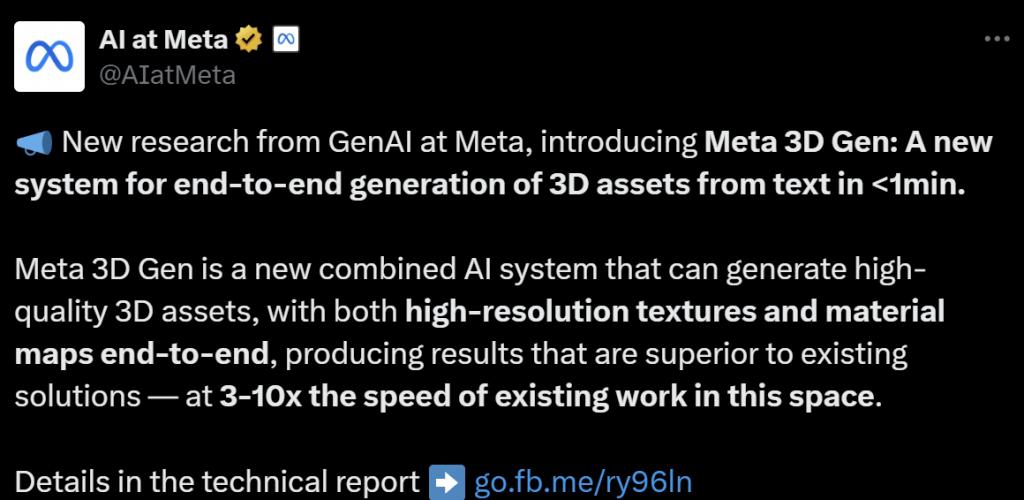

Meta 推出了一种名为 Meta 3D Gen 的端到端 3D 素材生成模型,可以在不到一分钟的时间内根据文本描述创建高质量的 3D 素材。

图源 :X ( @AIatMeta )

Meta 3D Gen 结合了 Meta 的两个现有模型:用于生成 3D 网格素材的 AssetGen 和用于精细纹理化的 TextureGen。 Meta 表示,这种集成可以为沉浸式内容带来更高质量的 3D 生成。

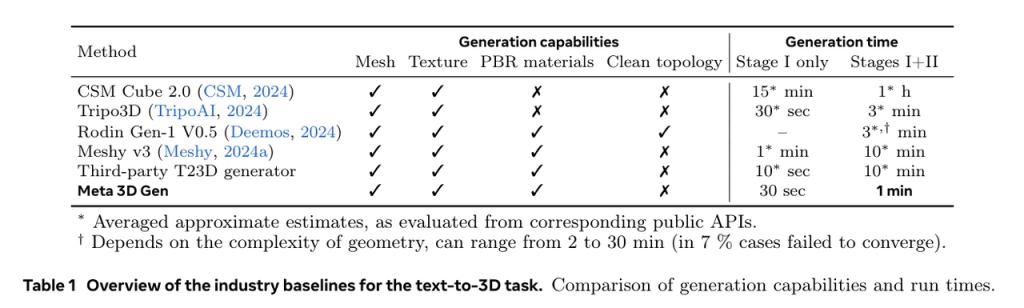

据 Meta 称,3D Gen 在速度和质量方面都超过了领先的行业解决方案。技术报告中称,专业 3D 艺术家在大多数类别中对该工具的评分都好于竞争对手,特别是对于复杂的请求。Meta 表示,**它的速度是同类系统的 3 到 60 倍。**

VR 行业发展速度不及预期,其中一个最重要的原因就是创建内容的成本过高,很难吸引内容创作者为元宇宙创建素材。而且人工创建的 VR 3D 素材质量因为硬件性能等各种因素的限制,相比平面素材过于 " 简陋 ",使得用户的沉浸感不足。

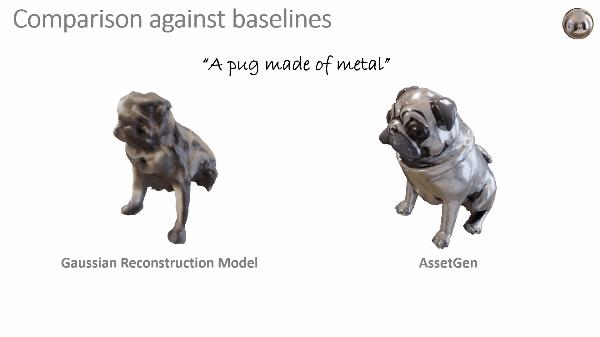

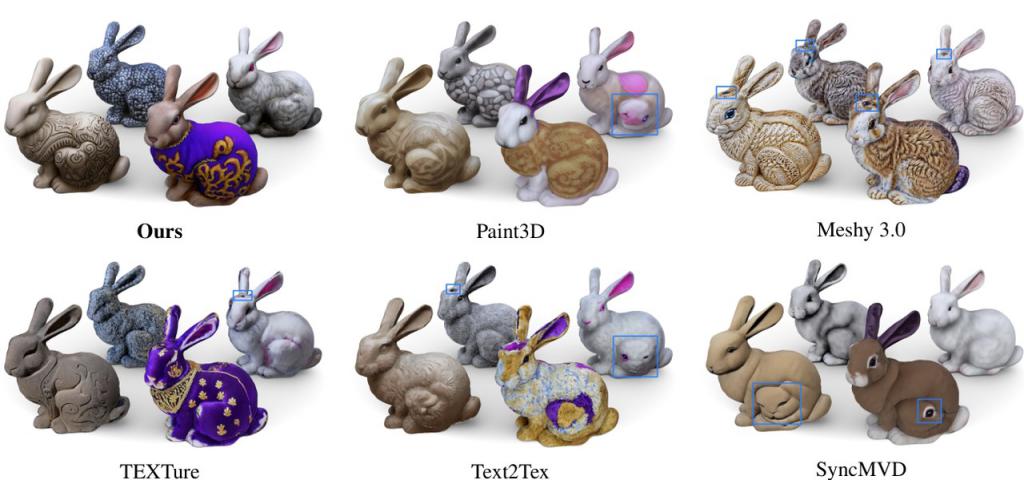

和现有的业界产品(Meshy、Tripo 等)相比,Meta 的 Gen 3D 生成的效果确实要好上不少,而且用时还是最少的。图源:Meta 论文

而如果用户能够非常方便且高效地创造 3D 素材,至少将能大大改善 VR 内容缺乏的问题。如果素材的质量再能得到进一步的提高,生成的虚拟现实世界真的能够达到以假乱真的地步。在 Gen AI 的加持之下,也许 VR 中的虚拟世界未来要成为第一个 AI 生成比例大于人工生成的领域。

也许小扎的 VR 梦,在 AI 的加持下,就真的要成了。

图源 :X ( @KaladinFree )

网友惊呼:这个技术对于 VR 以及 Meta 自身的发展策略来说太重要了。Meta 可能是除了英伟达以外 AI 发展最大的赢家!

图源 :X ( @sonieashan )

从文本到 3D,是怎样炼成的?

从文本提示词生成 3D 素材的模型,在 3D 图形、动画、游戏和 AR/VR 等领域都具有巨大的发挥潜力。

虽然在文生图和文生视频模型领域,已经取得了世界瞩目的进展(例如 MidJourney、Sora、Runway 等等),但在 3D 生成模型领域,以往的模型质量仍然不足以用于专业用途。

**以往 3D 生成模型有很多缺陷,比如生成速度慢,生成的 3D 网格和纹理中存在伪影。此外,以往的很多模型仍然将物体外观渲染为固有的颜色,忽略了 3D 物体的颜色应该随着环境光的变化而变化**。特别是对于反光材料,当把它们放置在新环境中时,它们会显得格格不入。

而 Meta 的 3D Gen 能在不到 30 秒内生成 3D 素材,相比于以往具有同等速度的模型,在保真度、生成的 3D 网格质量、特别是材料的质量和控制等方面,表现更好。

3D Gen 是如何做到如此栩栩如生的 3D 素材生成的呢?

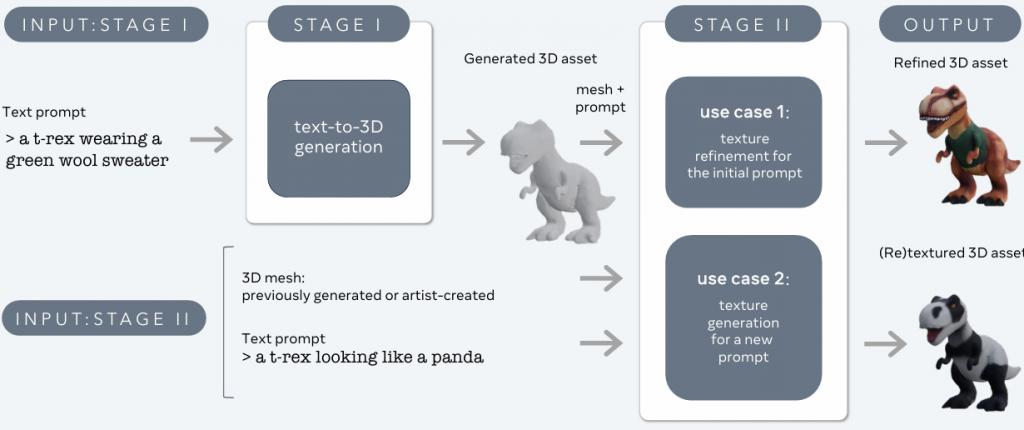

3D Gen 采用了两阶段的方法,结合了两个组件,第一阶段使用 AssetGen 组件,第二阶段使用 TextureGen 组件。

第一阶段:从文本到图像

这一阶段的目标是,从文本生成有着色和阴影的图像,从四个标准视角,生成这些角度的 4 张视图。为此,Meta 团队使用了一个经过预训练的文生图的扩散模型,该模型在数十亿张带标签的图像上进行训练。

第一阶段的推理时间约为 30 秒。

左为其他模型效果,右为 3D Gen 模型效果。图源:Meta 论文

和其他 3D 素材生成模型相比,Meta 的 AssetGen 的细节,光照的效果都明显要丰富和真实得多。

值得一提的是,Meta 团队使用的这个文生图模型,其架构与国内智源研究院的「悟道 3.0」Emu 开源多模态模型类似。

第二阶段:从图像到 3D

根据第一阶段生成的 3D 素材和最初的文本提示词,**对第一阶段的素材进行纹理细化或者重新着色,来生成更高质量的纹理和 PBR(physically based rendering,基于物理的渲染)图 **。这一阶段使用了 Meta 团队的从文本到纹理( text-to-texture)的生成模型 3D TextureGen。

第二阶段推理时间约为 20 秒。

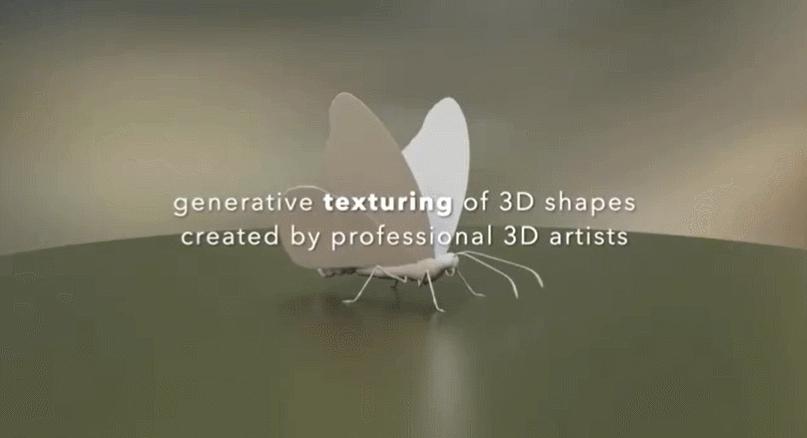

相比业内其他技术,Meta 的 TextureGen 生成的纹理质量非常高。图源:Meta 论文

通过构建 AssetGen 和 TextureGen 两个组件,3D Gen 模型将 3D 物体的三种高度互补的表现方式结合起来:视觉空间(图像)、体积空间(3D 形状和外观)以及 UV 空间(纹理与质地)。

与许多最先进的解决方案不同,AssetGen 和 TextureGen 都是前馈生成器,因此在部署后既快速又高效。

下图显示了 3D Gen 从第一阶段到第二阶段处理后的效果对比。第二阶段后通常具有更高的视觉美学,看起来更逼真,并且在高频颜色区有更多细节。

△第一阶段效果。图源:Meta 论文

△第二阶段处理后的效果。图源:Meta 论文

Meta 团队将 3D Gen 与其他文生 3D 模型同行们(Meshy v3、Tripo 等)进行了比较。Meta 表示,竞争对手们在简单物体上做得很好,但更复杂的物体组合和场景就有挑战了,而且展现高频区细节与暴露视觉伪影之间总是难以平衡。

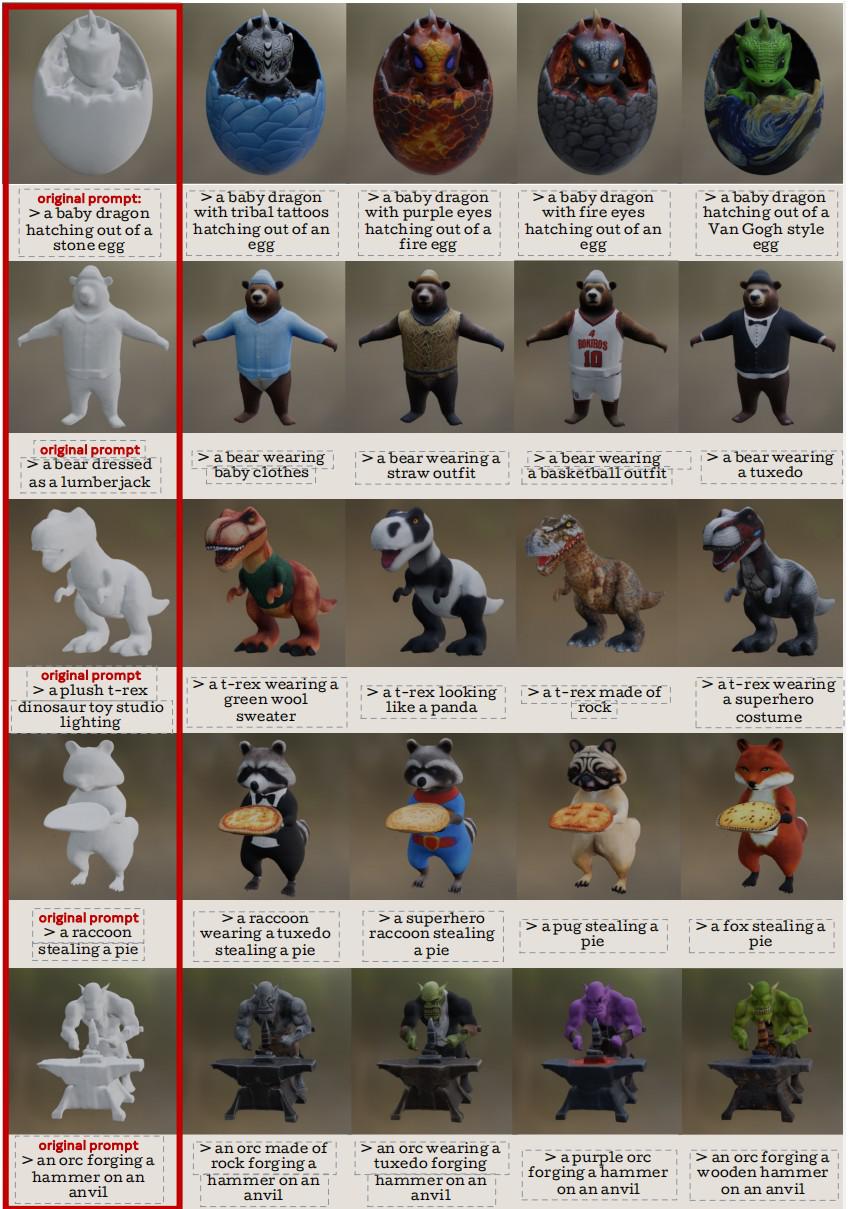

3D Gen 还可以在同一形状的物体上,进行不同的着色。在第一阶段生成的 3D 网格,然后传递到第二阶段,只要使用不同的提示词,就能创建具有相同形状但外观不同的新素材。除了实现语义编辑并执行全局和局部修改之外,3D Gen 还可以成功地模仿不同的材料和艺术风格。

在同一形状的物体上,进行不同的着色

除了对物体本身进行不同着色,3D Gen 还能调整整体场景的风格。通过对物体层面的提示词进行加强,加上风格信息,就能将整个场景的风格进行调整,效果很协调。

在下图中,3D Gen 就对同样的物体,进行不同风格的场景渲染,有针织玩偶、恐怖电影、水下世界、像素艺术、圣诞节等风格。

调整整体场景的风格

90 后研发团队

Gen 3D 的研发团队也非常年轻,基本都是由 90 后组成。

**Raphael Bensadoun**

Raphael Bensadoun

他毕业于特拉维夫大学,之后在两家小公司有过时间不长的工作经历,之后来到 Meta 成为了 AI 研究人员。

**Tom Monnier**

Tom Monnier

他毕业于法国最好的工程师大学,然后在 Tinyclues 和 Adobe 工作了一段时间之后,进入 Meta 担任研究科学家。

**Filippos Kokkinos**

Filippos Kokkinos

他是 Meta GenAI 的研究科学家,此前曾在 Facebook AI Research ( FAIR ) 工作。他的研究以生成性深度学习为中心,特别关注视频和从文本、图像和视频生成 3D 的技术。在加入 Meta 之前他曾经在华为等公司实习过。

他博士毕业于伦敦大学学院。

Meta 的 3D Gen 的潜在应用是巨大的。游戏开发人员可以用 3D Gen 快速制作游戏环境和角色原型,建筑可视化公司则只需要文本描述,就能生成建筑物整体和内部的详细 3D 模型,简化设计流程。在 VR/MR 领域,3D Gen 可以快速创建沉浸式环境和物体,加速元宇宙应用程序的开发。AI 的未来将会进一步加速。

-

- 不断“攻伐”的智己汽车,能走出销量“焦虑”吗?

-

2024-07-05 04:01:34

-

- 小红书电商,练起了“左右互搏”

-

2024-07-05 03:59:18

-

- 千亿电动牙刷市场,徕芬难以复刻“戴森平替”

-

2024-07-05 03:57:02

-

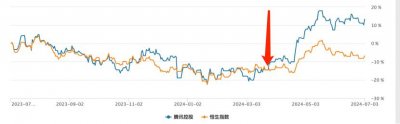

- “倒霉”的腾讯:“复苏”还是“回光返照”?

-

2024-07-05 03:54:46

-

- 女子从出版业转行做10年环卫:没有任何心理落差

-

2024-07-05 03:52:30

-

- 捞上来又滑下去!男子雨天钓鱼落水3次,辅警连捞3回

-

2024-07-04 07:00:31

-

- 盘点生双胞胎的6对明星: 前5位有一对双胞胎, 第6位有两对双胞胎!

-

2024-07-04 06:58:14

-

- 又一位明星恋情曝光,男友脱外套为她取暖,相约看房好事将近?

-

2024-07-04 06:55:59

-

- 泽连斯基:可以与俄罗斯进行和谈 需要采取“第三国调解”模式

-

2024-07-04 06:53:43

-

- 又一新疆美女出道, 比热巴娜扎还美, 已经是陈赫“动霸影业”

-

2024-07-04 06:51:27

-

- 姚明和奥尼尔球场打架,麦迪眼神霸气逼人,秒杀对手

-

2024-07-04 06:49:11

-

- 雍正王朝5大角色智力排名:老八垫底,雍正仅第三,第一无人不服

-

2024-07-04 06:46:56

-

- 骑无牌共享电单车被罚,板子莫打偏

-

2024-07-04 06:44:40

-

- 养盆“多叶芦荟”,不仅叶片肥,还便宜、好养活,几月不管也长爆

-

2024-07-04 06:42:24

-

- 小智谈帝师出事: 我送走了许多人, 这次可能要送走帝师了

-

2024-07-04 06:40:08

-

- 中国版超级“星链”将干掉马斯克?!将发1.4万颗卫星覆盖全球,亚马逊丛林也能

-

2024-07-03 06:03:14

-

- 万达北京部分员工搬到珠海:横琴房产中介忙着带看,“业主电话快被打爆了”

-

2024-07-03 06:00:57

-

- 大模型,中东土豪的新「时尚单品」

-

2024-07-03 05:58:42

-

- 一年开店16万家,新茶饮集体闯关IPO

-

2024-07-03 05:56:26

-

- 九宫格直播造富:“大哥”砸千万打赏,主播月入20万

-

2024-07-03 05:54:10

港政务司长陈国基:区议会选举不能选非爱国者

港政务司长陈国基:区议会选举不能选非爱国者 福建各县市区人均GDP和总量,宁德人均第三,漳州总量第十

福建各县市区人均GDP和总量,宁德人均第三,漳州总量第十 盘点10位世界级的大元帅,各个都军功卓越,中国有1位上榜

盘点10位世界级的大元帅,各个都军功卓越,中国有1位上榜 今年最火 90 后创始人:稚晖君

今年最火 90 后创始人:稚晖君 为什么叫双一流大学 为什么叫双一流学校

为什么叫双一流大学 为什么叫双一流学校 湖南省排名的城市 湖南十大城市排名

湖南省排名的城市 湖南十大城市排名 Intel发布14代酷睿S系列处理器,性能猛增37%!

Intel发布14代酷睿S系列处理器,性能猛增37%! 当年35岁产妇产下全国首例“5胞胎”,20年过去了,他们过得咋样

当年35岁产妇产下全国首例“5胞胎”,20年过去了,他们过得咋样 考公背后,这些公司是怎么闷声发财的

考公背后,这些公司是怎么闷声发财的